Clasificación

Lo primero que hace la comisión europea es clarificar que las inteligencias artificiales (IA) están basadas en modelos probabilísticos y por tanto pueden cometer errores.

En segundo lugar la Unión Europea (UE) elige la evaluación de riesgos sobre los derechos fundamentales y la adecuación de los códigos de conducta como base para la construcción de la norma.

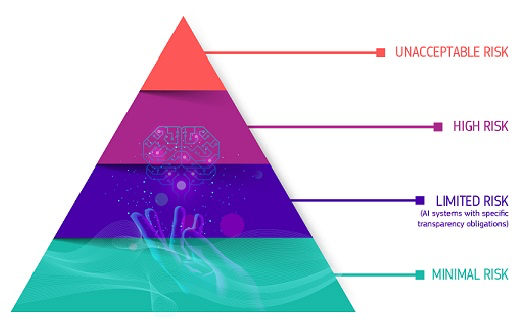

De esta forma clasifica los riesgos en inaceptables, altos, limitados y mínimos.

Fuente: https://digital-strategy.ec.europa.eu

También deja muy claro que la supervisión de las IA debe ser realizada por humanos y no por otro tipo de automatizaciones como por ejemplo otras IA.

Creemos que este punto es muy importante, por que cada vez se detecta una tendencia mayor a que las IA sean “supervisadas” por otras IA.

En este contexto, debido a que las IA son finalmente modelos probabilísticos y por tanto sujetos a errores, hace una clasificación de estas dependiendo de la finalidades para las que se diseñan.

Riesgo inaceptable

Siendo estas las que suponen un riesgo cierto sobre los derechos de las personas. Estas IA están enumeradas en el título II de la norma. En este grupo están:

- IA que puedan manipular el comportamiento cognitivo de las personas. Por ejemplo aquellas que puedan invitar a comportamientos violentos o que intenten la manipulación, mediante técnicas subliminales del comportamiento de las personas.

- IA que puedan clasificar a las personas en función de sus comportamientos.

- IA que sean usadas para el reconocimiento biométrico masivo, como por ejemplo hace el gobierno chino.

- Estás IA están completamente prohibidas excepto en algún caso donde su finalidad sea la persecución de delitos y en este caso nunca en tipo real. Por ejemplo se puede usar una IA para reconocimiento facial para perseguir delitos graves, siempre que esta IA se aplique sobre imágenes que hayan sido obtenidas hace tiempo (este límite temporal no lo deja definido y entendemos que en la transposición que haga cada país de la norma quedarán definidos) y siempre con autorización judicial.

Alto riesgo

Siendo estas las que puedan afectar de manera negativa a la seguridad o a los derechos fundamentales. Estas inteligencias artificiales se deben ser evaluadas antes de su uso y durante todo el ciclo de vida. Los ciudadanos de la Unión pueden presentar reclamaciones sobre estas durante su uso delante de las autoridades locales de cada país miembro. Estas IA se clasifican en dos:

- Los sistemas de IA que se utilicen en productos sujetos a la legislación de la UE sobre seguridad de los productos. Esto incluye juguetes, aviación, automóviles, dispositivos médicos y ascensores.

- Los sistemas de IA cuya finalidad sea alguna de las detalladas a continuación, por su especial finalidad deben ser registradas en una base que la UE destinará a este fin y por tanto serán motivo de un especial escrutinio:

- identificación biométrica y categorización de personas físicas

- gestión y explotación de infraestructuras críticas

- educación y formación profesional

- empleo, gestión de trabajadores y acceso al autoempleo

- acceso y disfrute de servicios privados esenciales y servicios y prestaciones públicas

- aplicación de la ley

- gestión de la migración, el asilo y el control de fronteras

- asistencia en la interpretación jurídica y aplicación de la ley.

- Los sistemas clasificados de alto riesgo deberán guardar un registro de cada una de las iteraciones con al menos la siguiente información:

- Un registro del período de cada uso del sistema (la fecha y la hora de inicio y la fecha y la hora de finalización de cada uso)

- La base de datos de referencia con la que el sistema ha cotejado los datos de entrada

- Los datos de entrada con los que la búsqueda ha arrojado una correspondencia

- La identificación de las personas físicas implicadas en la verificación de los resultados. Dejando claro que la supervisión de los sistemas siempre debe ser realizada por humanos y no por máquinas.

- Las IA clasificadas como alto riesgo deben cumplir el siguiente ciclo de vida:

Riesgo limitado

Estas IA, básicamente las IA conversacionales que estamos acostumbrados a usar, no suponen un riesgo en si mismas, pero muy fácilmente pueden ser “confundidas” con humanos. Para evitar esto a UE obliga a un código de conducta para evitar esta confusión. Más adelante explicamos este código de conducta.

Riesgo mínimo

El resto de las aplicaciones de la IA.

Transparencia

Un requerimiento, que desde nuestro punto de vista es muy positivo es la necesidad de transparencia. La norma obliga a las IA clasificadas como de alto y limitado riesgo, pero parece interesante su aplicación a todas las IA, para evitar la desconfianza de los usuarios.

Nosotros como usuarios de una IA, ¿no nos gustaría siempre, ser conscientes de que estamos interactuando con una máquina, en lugar de con un humano?

Entre los requerimiento exigidos están:

- Ser claros en que el contenido generado ha sido generado, valga la redundancia, por una IA y no por un humano.

- Limitar las respuestas de la IA para evitar la generación de contenido ilegal.

- La publicación de resúmenes del texto usado para el entrenamiento cuando este esté protegido por derechos de autor.

- Etiquetar el contenido para que el usuario tenga claro que ha sido generado por una IA por ejemplo imágenes, vídeos, etc. Habrá que ver como se implementa esto, ya que como todos sabemos es muy fácil la eliminación de metadados o marcas de agua de este tipo de contenidos.

Muy probablemente nos encontraremos, como en otras ocasiones, la adopción de estas normas de transparencia a todas la IA (incluidas las de bajo riesgo) ya que es un forma de garantizar al usuario de estas IA y de las empresas que contraten los servicios de empresas que construyan IA los códigos de buenas prácticas dichos anteriormente.

Proceso de implementación

La comisión europea plantea la implantación en tres fases:

- Seis meses, después de su entrada en vigor, habrá obligación de dejar de usar las IA clasificadas como inaceptables.

- Nueve meses, después de su entrada en vigor, habrá obligación de adoptar el código de buenas practicas, como el de transparencia.

- Doce meses, después de su entrada en vigor, la IA de carácter general deberán cumplir el código de transparencia.

- Los sistemas de alto riesgo dispondrán de más tiempo para cumplir los requisitos, ya que las obligaciones que les conciernen serán aplicables 36 meses después de la entrada en vigor.

Conclusión

El mundo está en plena transformación y está claro que la IA está en el epicentro de esta transformación, pero es nuestra obligación garantizar que el cambio discurre dentro de los límites éticos que todos queremos salvaguardar.

Te invito a leer la continuación de esta entrada, donde resolveremos otras dudas sobre la norma aprobada por la UE.